いわゆるオレオレ詐欺などの「なりすまし詐欺」が、ビデオ通話でかかってくる時代がきてしまうかもしれません。顔や声をすり替えて、本人そっくりの虚偽映像を作り出す「ディープフェイク」のテクニックがどんどん進化しています。

2020年10月初旬には、アイドルや芸能人の顔をアダルトビデオに合成したフェイクポルノ動画を作成し、インターネット上に不特定多数向けに公開していた大学生の男らが、著作権法違反や名誉毀損の疑いで逮捕されました。

もしあなた自身や身近な人が、身に覚えのないポルノ動画に合成されてしまったり、本人であるかのように振る舞い、悪事をはたらいている姿が映っていたりしたら、どう思うでしょうか?

さて、そもそもディープフェイクとはどのようなものでしょうか。

海外で話題となっているニュースやフェイク動画、その仕組みや事例を知って、フェイク動画時代に備えましょう。

ディープフェイクとは?

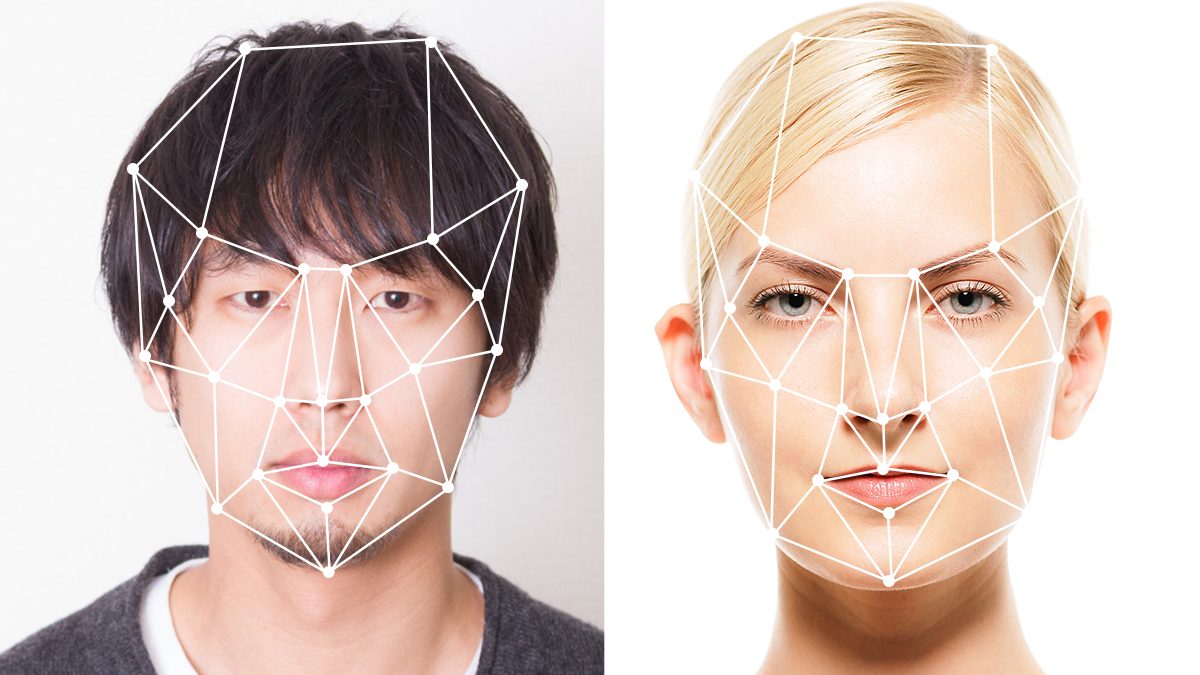

ディープフェイクとは、AIの「ディープラーニング」と「フェイク」を組み合わせた用語で、ディープラーニング(深層学習)技術を用いて作成された合成メディア(動画や音声など)です。

どのような動画があるか、まずはいくつか見てみましょう。

イギリスのテレビ局の2020年クリスマスメッセージ

こちらは、イギリスのテレビ局channel4が作成した、エリザベス女王のクリスマスメッセージです。

イギリスで恒例のクリスマスメッセージの後に、軽快なダンスを披露するエリザベス女王。

3分20秒あたりから種明かしがはじまりますが、お気づきのようにこの動画は合成で作られたもの。エリザベス女王は別人が演じており、ディープフェイクへの警鐘として放送されました。

この映像はテレビ局が作成したものであるため、声を変えていなかったりと不自然さを意図的に残しており、英国民であればすぐに偽物であることは気づく仕上がりになっているようですが、もっと精巧にフェイク動画を作ることは可能です。

政治的な印象操作を警鐘するフェイク動画

アメリカでは、オバマ元大統領が、トランプ前大統領を批判しているというフェイク動画が公開されていました。

こちらも、ディープフェイクの脅威を発信するため作られた動画ですが、非常に精巧であり、ディープフェイクは政治上の印象操作や国際問題にも発展しかねないことが伺えます。

外見の合成技術

合成技術というと、SF映画のメイキングに見られるような、特殊な環境やセットで撮影した動画をCGと合成したり、一コマずつ手作業で修正するといった、非常に手間もコストもかかる手順をイメージするかもしれません。

しかし、今やアプリケーションひとつで、一見しただけでは見分けのつかない映像が作り出せるようになっています。

2019年に発表されたFirst Order Motion Model というツールでは、1枚の静止画から顔の表情やスムーズな動きを簡単に作り出しています。表情だけではなく、異なる洋服でも全身のすり替えが可能です。

動画からアニメーションへの変換も可能であるため、今後、アニメーションのジャンルでも広く活用されていくでしょう。また、PIP(Person In Presentation)やVTuberのような、映像の中でのナレーションやレポーターの役割としても利用されるかもしれません。

このように考えると、有名人だけではなく、たまたま写真に写っている一般の人が合成され、映像の中で動いたり話したりする動画が公開される可能性があるのです。

映画撮影のような特別なセットや機材がなくとも、誰でも手軽に合成が可能な時代が訪れていることを、ぜひ心に留めて置いてください。

First Order Motion Modelに関する、日本向けのより詳しい解説は、こちらがおすすめです。

参考:First Order Motion Model で、モナリザをトランプ大統領のように動かす

音声の合成技術

2019年にイギリスで、合成音声を悪用し、22万ユーロ(約2,600万円)が騙し取られる詐欺事件が起きています。

あるエネルギー会社のCEOに、ドイツにある親会社のCEOから「ハンガリーにある口座へ22万ユーロを緊急で振り込んでほしい」との電話があったそうです。

電話を受けたCEOのことを名前で呼び、声は本人そっくりで、話し方やドイツ訛りまで再現されていたようです。

残念ながら詐欺に気づく前に振り込みは完了してしまい、22万ユーロ(約2,600万円)は、ハンガリーからメキシコの口座に移されてしまい、それ以降、行方不明となってしまっているようです。

参考:2,600万円詐取、AI使った“声のディープフェイクス”が仕掛けるオレオレ詐欺

日本での合成音声の話題としては、2020年の秋に、アイドルグループ「嵐」の音声を元に、「A・RA・SHI」を替え歌してくれるというジェネレーター「「A・NA・TA for DREAM」が発表されました(2020年末にコンテンツは終了)。スマートフォンから歌詞を入力するだけで、本人たちと遜色のない歌声が聞けると、SNSを中心に話題になっていました。

参考:A・NA・TA for DREAM作品集(ニコニコ動画)

また、2019年9月29日に放送され、大反響を巻き起こしたNHKスペシャル「AIでよみがえる美空ひばり」で披露されたAI歌唱も、音声合成技術の進化を世に知らしめた出来事でした。

参考:NHKスペシャル「AIでよみがえる美空ひばり」(YouTube)

ディープフェイクをどのように見分けるか?

ディープフェイクに関する悪いニュースが相次ぐ一方、もちろんフェイクを感知するアルゴリズムの開発も進められています。

人間の目では自然に見えても、合成処理を行うプロセスの中で、本物とフェイクとの明らかなデータ上の差異が発生しています。データの境界線を検知し、特定することができるアルゴリズム「Face X-ray」を利用することで、合成動画かどうかを判定できます。

しかし、現在使われている手法でのディープフェイクのみに有用であり、合成とは異なる手段でのフェイクや新しい手法については見破ることが難しいとされており、まさに技術のイタチごっこ状態といえます。

参考:あらゆるディープフェイクを見破る「Face X-ray」Microsoftが取り組むSOTAな技術とは?

ディープフェイクに騙されないための心構え

一人ひとりがディープフェイクやフェイクニュースに騙されないためには、本物との違いに気づくことや、複数の方法で確かめることが重要です。

- 映像に違和感がないか?

- 情報源(ソース)は信頼できるところか?

- 複数のメディアで発信されている情報か?

動画の人物だけではなく、背景や小物の光や影に違和感がないかなどを注意深く見るようにするとよいでしょう。

違和感を抱いたら、その動画に関する情報を集めましょう。過去に話題となったフェイク動画であれば、ニュースサイトなどで取り上げられている可能性があります。先述のフェイク動画を見抜くAIで解析済み、というケースも考えられます。

また、真偽が不明な情報は拡散しないことも大切です。虚偽の情報がさらに第三者へ流通してしまうことにより、無意識にフェイクやデマ情報の流布に加担してしまう可能性があるからです。

まとめ

目覚ましい技術の発展の裏、心が痛むニュースが目立ってしまいますが、もちろん悪用されるために産まれた技術ではありません。

特撮ヒーローのスーツアクターやホラー映画の特殊メイクのように、人物が変身したり、身体的に大きく変化した姿が合成技術で可能になったり、撮影済みの映像のキャスティング変更が、撮りなおしではなく合成技術で処理されたりする日が来るかもしれません。

また、オレオレ詐欺などの特殊詐欺がいまだに横行しているように、声については顔よりも記憶に止まりにくく、本人かどうかを正確に判断しにくいもの。身近な相手との会話であっても、話の中身に気を取られ、だいたいの声の印象しか記憶していないかもしれません。

家族や友人と一緒に、ボイスレコーダーで会話を録音し、声や話し方の特徴、実際の声と録音した声との違いなどを確認し合うとよいでしょう。